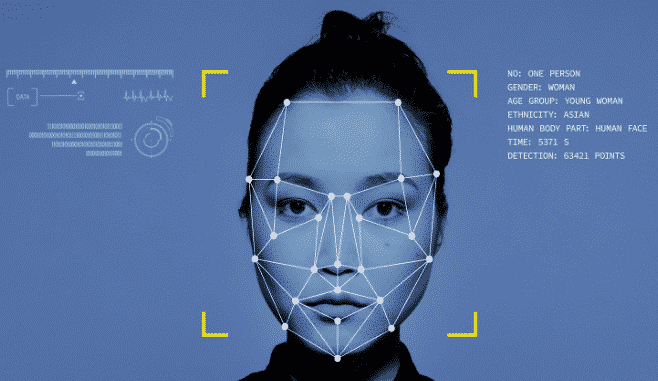

Constantemente somos orientados a ver o universo da Inteligência Artificial (IA) com bons olhos, afinal o entusiasmo com o qual essa tecnologia é exposta nos faz acreditar apenas em seus benefícios para a sociedade. Porém, na prática não funciona dessa forma e é isso que o documentário Coded Bias expõe, através da divulgação de vários estudos que comprovam o viés de gênero e de raça embutidos nos algoritmos que estão por trás das principais tecnologias de reconhecimento facial do mundo.

Dessa forma, Coded Bias, documentário americano dirigido por Shalini Kantayya, propõe uma reflexão sobre a criação de tecnologias de reconhecimento biométrico-facial desenvolvidas por um grupo pequeno e homogêneo de pessoas e sobre o seu uso sem uma regulação específica. Além disso, o documentário mostra estudos onde são encontradas falhas que demonstram vieses de raça e gênero e problemáticas relacionadas à Privacidade e Proteção de Dados.

O Reconhecimento Biométrico-Facial

O que começou como um simples recurso fotográfico é hoje, com o avanço dos estudos sobre IA, um sistema presente em diversos meios: desde aplicativos comerciais até sistemas complexos de segurança governamental.

No novo documentário produzido pela Netflix, uma das principais personagens é Joy Buolamwini, cientista de computação do MIT (Instituto de Tecnologia de Massachusetts) e criadora do conceito da máscara branca (White Mask). Buolamwini inicia sua pesquisa sobre Reconhecimento Facial ao perceber que os seus algoritmos de código-aberto não conseguiam identificar a sua pele negra e a partir disso, com a ajuda de algumas organizações, ela começa a investigar e propor a proibição do uso desse tipo de tecnologia nos Estados Unidos.

No Brasil, a Lei Geral de Proteção de Dados (LGPD) define o reconhecimento facial como um dado pessoal sensível, uma vez que é considerado dado biométrico, o que exige um cuidado mais rigoroso em seu tratamento. No entanto, a própria LGPD esclarece que ela não se aplica ao tratamento de dados pessoais realizado para fins exclusivos de segurança pública, defesa nacional, segurança do Estado ou atividades de investigação e repressão de infrações penais.[1]

Com o intuito de preencher a lacuna sobre a regulação da utilização dos dados pessoais na segurança pública foi proposto um anteprojeto de lei no Brasil, popularmente conhecido como PL da “LGPD Penal”. O anteprojeto de lei de proteção de dados na segurança pública possui o objetivo de assegurar que o cidadão tenha o controle das informações que o identificam, além disso é de extrema importância para a prevenção de riscos e manutenção dos direitos digitais no Brasil. De acordo com o Instituto de Referência em Internet e Sociedade, essa regulação é essencial para que não ocorram falsos positivos no reconhecimento facial que possam embasar abordagens policiais violentas e discriminatórias, por exemplo.

Uma pesquisa do Instituto Igarapé revelou que desde 2011 são utilizados Sistemas de Reconhecimento Facial no Brasil para diferentes finalidades, principalmente na segurança pública. A Lei nº 13.964, de 2019 (Aperfeiçoamento da legislação penal e processual penal) prevê o armazenamento de dados de registros biométricos, de impressões digitais e, quando possível, de íris, face e voz, para subsidiar investigações criminais.[2]

§ 4º Poderão ser colhidos os registros biométricos, de impressões digitais, de íris, face e voz dos presos provisórios ou definitivos quando não tiverem sido extraídos por ocasião da identificação criminal.

A Portaria nº 4.617, de 6/4/2021, do Ministério da Ciência, Tecnologia e Inovações, instituiu recentemente a Estratégia Brasileira de Inteligência Artificial (BIA), que assume o papel de nortear as ações do Estado brasileiro para o uso da IA. Outro objetivo da Estratégia é garantir a inovação no ambiente produtivo e social na área de Inteligência Artificial.

Regulação da Inteligência Artificial no Brasil e no Mundo

Apesar de serem considerados como um grande avanço para a tecnologia, os sistemas que utilizam IA ainda estão em processo de regulação, tanto no Brasil quanto no Mundo.

No Brasil, tramitam alguns Projetos de Lei no Congresso Nacional, ainda em fase inicial, que envolvem a regulação da Inteligência Artificial, seja através de uma Lei Geral ou do estabelecimento de princípios para seu uso. Entre eles estão o PL 5051/2019 que tramita no Senado e estabelece os princípios para o uso da Inteligência Artificial no Brasil, e o PL 21/2020 que cria o marco legal do desenvolvimento e uso da Inteligência Artificial (IA) pelo poder público, empresas, entidades diversas e pessoas físicas tramita na Câmara dos Deputados.

Recentemente publicamos no nosso Blog um artigo sobre a Proposta de Regulação para Inteligência Artificial na Europa, nela a Comissão Europeia propôs ao Parlamento Europeu a atualização das regulações sobre o desenvolvimento e utilização de Inteligência Artificial na União Europeia, proibindo a implementação de IA para influenciar ou distorcer o comportamento de uma dada pessoa de modo a fazer mal físico ou psicológico a ela por meio de técnicas subliminares de manipulação, dentre outras proibições.

Quando o quesito é avanço em novas tecnologias a China encontra-se como um dos países que mais investem no setor e já possui diversos sistemas de Reconhecimento Biométrico-Facial em funcionamento no país. O uso de IA no país mais populoso do mundo ainda está imerso em muitas controvérsias relacionadas aos objetivos da utilização dos sistemas pelo governo e sobre o uso do mecanismo de Social Scoring.

Em junho de 2019, a China publicou, através do Comitê de Especialistas em Governança de IA da Nova Geração, os seus “Princípios de Governança da IA”. O documento fornece uma estrutura e diretrizes para promover o desenvolvimento saudável de soluções baseadas na tecnologia e define que deverão ser estabelecidos padrões para a coleta, armazenamento, processamento e uso de informações pessoais. [3]

Além do estudo de Buolamwini, o documentário apresenta diversos trabalhos de outros pesquisadores e ativistas que lutam contra o uso indiscriminado da tecnologia de reconhecimento facial sem regulação. Entre os grupos citados está a Liga da Justiça Algorítmica, que conseguiu algumas vitórias na esfera política dos Estados Unidos, incluindo o projeto de lei que espera banir os sistemas de reconhecimento facial do país.

A Liga da Justiça Algorítmica

Muito citada no documentário, a Liga da Justiça Algorítmica (Algorithmic Justice League) se autodenomina como uma organização que combina arte e pesquisa para iluminar as implicações sociais e os danos da inteligência artificial e possui como missão aumentar a conscientização pública sobre os impactos da IA, equipar defensores com pesquisas empíricas para apoiar campanhas, construir a voz e a escolha das comunidades mais afetadas e apoiar pesquisadores, legisladores e profissionais da indústria para mitigar preconceitos e danos à IA. [4]

Agora vivemos em um mundo onde a IA governa o acesso à informação, oportunidade e liberdade. No entanto, os sistemas de IA podem perpetuar o racismo, sexismo e outras formas prejudiciais de discriminação, portanto, apresentando ameaças significativas à nossa sociedade – desde saúde, oportunidades econômicas e nosso sistema de justiça criminal.

Algorithmic Justice League

O que as startups podem aprender com o Coded Bias?

Quando pensamos em algoritmos e inovação tecnológica nos remetemos ao universo das startups, visto que, atualmente, elas são o motor do desenvolvimento tecnológico no mundo. Dessa forma, é imperioso que ao desenvolverem suas novas tecnologias de ponta, atentem-se para a diversidade nas informações inseridas em seus bancos de dados que são utilizados na arquitetura de suas aplicações.

Outro ponto que destacamos é a utilização de princípios do privacy by design no desenvolvimento de sistemas baseados em algoritmos. O emprego dessa metodologia reflete na entrega de um produto (sistema ou aplicação) onde o respeito à privacidade do usuário está presente durante toda a sua navegação e usabilidade, implicando na aderência e conformidade aos preceitos estabelecidos na LGPD.

Fontes:

[1]Disponível em: <https://www.conjur.com.br/2021-abr-15/miziara-hirata-coded-bias-identificacao-biometrico-facial> Acesso em 29/04/2021.

[2]Disponível em: <https://igarape.org.br/infografico-reconhecimento-facial-no-brasil/> Acesso em 29/04/2021.

[3] Disponível em: <https://www.loc.gov/law/foreign-news/article/china-ai-governance-principles-released/> Acesso em 29/04/2021.

[4]Disponível em: <https://www.ajl.org/about> Acesso em 29/04/2021.

BL Consultoria e Advocacia Digital

Escritório jurídico voltado para o mundo conectado que busca auxiliar empresas e startups a desenvolverem seus projetos (Pesquisa, Desenvolvimento e Inovação) de forma ética e eficiente com atuação especializada em Direito Digital e Análise Regulatória para novas tecnologias. Estamos localizado em dois endereços: em São Paulo-SP, na Av. Paulista, 575 – conjunto 1903 – Bela Vista, CEP 01311-911 e em Campinas-SP, na Rua Antônio Lapa, 280 – 6o andar, Cambuí.